Quando profissionais de marketing criam landing pages, escrevem e-mails ou desenham botões de call-to-action, pode ser tentador usar a intuição para prever o que fará as pessoas clicarem e converterem mais.

Interessado em aprender sobre teste A/B mas está naquela correria? Aperte o play e ouça o artigo na íntegra!

Mas basear as decisões de marketing apenas no “feeling” pode ser muito prejudicial para os resultados. Ao invés de confiar em suposições para tomar essas decisões, é muito melhor executar testes de otimização da taxa de conversão (CRO) – um dos mais conhecidos é o teste A/B.

O teste A/B é valioso porque diferentes públicos se comportam de maneiras diferentes. Algo que funciona para uma empresa pode não funcionar necessariamente para outra.

Na verdade, os especialistas em CRO odeiam o termo “melhores práticas” porque talvez não seja a melhor prática para você.

Mas esses testes também podem ser complexos. Se você não for cuidadoso, pode fazer suposições incorretas sobre o que as pessoas gostam e o que as fazem clicar – decisões que poderiam facilmente desajustar outras partes da sua estratégia.

Continue lendo para aprender o que é teste A/B, ferramentas úteis e como fazer o seu teste para tomar as melhores decisões com base nos seus resultados.

O que é o teste A/B?

Um dos tipos mais fáceis (e mais comuns) de testes de CRO é chamado teste A/B.

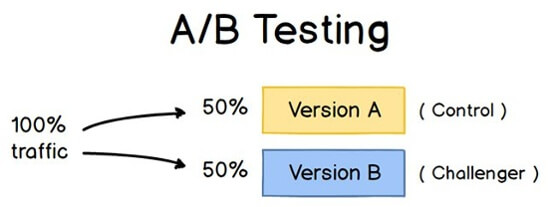

Também conhecido como teste de divisão, o teste A/B retém parte do seu público para testar diversas variações de uma campanha ou projeto.

Em outras palavras, você está observando como uma versão de um conteúdo de marketing se comporta ao lado de outra ou um botão de call-to-action (CTA) verde versus um botão vermelho, para ver qual apresenta melhor desempenho.

Para executar um teste A/B, você precisa criar duas versões diferentes de uma parte do conteúdo, com alterações em uma única variável. Em seguida, você mostrará essas duas versões para dois públicos-alvo de tamanho semelhante e analisará qual deles teve melhor desempenho.

Por exemplo, digamos que você queira ver se a movimentação de um determinado botão de call-to-action para o topo da sua página inicial, em vez de mantê-lo na barra lateral, vai melhorar sua taxa de conversão.

Para fazer um teste A/B com essa alteração, você criaria outra página da web alternativa que refletisse a alteração da veiculação de CTA. O design existente – ou o “controle” – é a versão A. A versão B é o “desafiador”.

Fonte: CXL

Em seguida, você testa essas duas versões mostrando cada uma delas para uma porcentagem pré-determinada de visitantes do site.

A seguir temos uma lista de recomendações de ferramentas para teste A/B e na sequência vamos ver como configurar esse tipo de teste.

Ferramentas para testes A/B

Como realizar testes A/B

1. Escolha uma variável para testar

Ao otimizar suas páginas da web e e-mails, você pode descobrir que existem muitas variáveis para testar.

Mas, para avaliar a eficácia de uma mudança, você deverá isolar uma “variável independente” e medir seu desempenho. Caso contrário, você não pode ter certeza de qual delas foi responsável por alterações no desempenho.

Você pode testar mais de uma variável para uma única página da web ou e-mail. Apenas tenha certeza de que você está testando uma de cada vez.

Veja os vários elementos em seus recursos de marketing e suas possíveis alternativas de design, redação e layout. Outras coisas que você pode testar incluem linhas de assunto de e-mail, nomes de remetentes e maneiras diferentes de personalizar seus e-mails.

Lembre-se de que até mesmo alterações simples, como a alteração da imagem em seu e-mail ou as palavras no botão de call-to-action, podem gerar grandes melhorias. Na verdade, esses tipos de mudanças são geralmente mais fáceis de medir do que as maiores.

2. Identifique seu objetivo

Embora você avalie um número de métricas para cada teste, escolha uma métrica principal para se concentrar – antes de executar o teste. Na verdade, faça isso antes mesmo de configurar a segunda variação. Esta é sua “variável dependente”.

Pense em onde você deseja que essa variável esteja no final do teste de divisão. Você pode declarar uma hipótese oficial e examinar seus resultados com base nessa previsão.

Se você esperar para pensar em quais métricas são importantes para você, quais são suas metas e como as alterações propostas podem afetar o comportamento do usuário, talvez não seja possível configurar o teste da maneira mais eficaz.

3. Crie um ‘controle’ e um ‘desafiante’

Agora você tem sua variável independente, sua variável dependente e seu resultado desejado. Use essas informações para configurar a versão inalterada do que você está testando como seu “controle”.

Se você está testando uma página da web, esta é a página como ela já existe. Se você está testando uma landing page, este seria o design que você usaria normalmente.

A partir daí, crie uma variação ou um “desafiante”: o site, a landing page ou o e-mail que você testará contra seu “controle”.

Por exemplo, se você estiver se perguntando se incluir um depoimento em uma landing page faria diferença, configure sua página de controle sem nenhum depoimento. Em seguida, crie sua variação com um depoimento.

4. Divida seus grupos iguais e aleatoriamente

Para testes em que você tem mais controle sobre o público – como com os e-mails – é necessário testar com dois ou mais públicos-alvo iguais para obter resultados conclusivos.

Como você faz isso irá variar dependendo da ferramenta de teste A/B que você usa.

O plano Enterprise da HubSpot inclui uma ferramenta para condução de teste A/B em um e-mail, por exemplo, que já divide automaticamente o tráfego para as variações, de modo que cada uma receba uma amostra aleatória de visitantes.

Outras ferramentas, como o RD Station Marketing, também possui uma solução de teste A/B para disparo de e-mails.

5. Determine o tamanho da amostra (se aplicável)

O modo como você determina o tamanho da amostra também varia dependendo da ferramenta de teste A/B, bem como do tipo de teste A/B que você está executando.

Se você fizer um teste A/B de e-mail, provavelmente você deseja enviar um teste A/B para uma parte minimamente relevante da sua lista para obter resultados estatisticamente significativos.

Eventualmente, você escolherá um vencedor e enviará a variação vencedora para o resto da lista.

6. Decida quão significativos seus resultados precisam ser

Depois de escolher sua métrica principal, pense em como seus resultados devem ser significativos para justificar a escolha de uma variação sobre a outra.

O significado estatístico é uma parte super importante do processo de teste A/B, que é muitas vezes mal compreendido.

Quanto maior a porcentagem do seu nível de confiança, mais certeza você terá sobre seus resultados. Na maioria dos casos, você precisará de um nível de confiança de no mínimo 95% – de preferência até mesmo 98% – especialmente se for um experimento demorado para configurar.

No entanto, às vezes, faz sentido usar uma taxa de confiança menor se você não precisar que o teste seja tão rigoroso.

Um exemplo em que se poderia sentir mais segurança em reduzir o limite de confiança é um experimento que provavelmente vai melhorar a taxa de conversão em 10% ou mais, como uma seção redesenhada.

A conclusão aqui é que quanto mais radical a mudança, menos científico é preciso ser no processo. Quanto mais específica for a alteração (cor do botão, tamanho, etc.), mais científico devemos ser, porque é menos provável que a alteração tenha um impacto grande e perceptível na taxa de conversão.

7. Verifique se você está executando apenas um teste por vez em qualquer campanha

Testar mais de uma coisa para uma única campanha – mesmo que não seja exatamente o mesmo ativo – pode complicar seus resultados.

Por exemplo, se você fizer um teste A/B para uma campanha de e-mail direcionada para uma landing page ao mesmo tempo em que testa essa landing page, como saber qual alteração causou o aumento de leads?

Teste A/B: caso VOOOZER

Por Albert Hayfaz

Uma parte importante da estratégia de conteúdo do VOOOZER é o envio de newsletters. Essa prática mantém nossa base informada sobre os novos materiais e gera um fluxo de audiência relevante para o nosso blog.

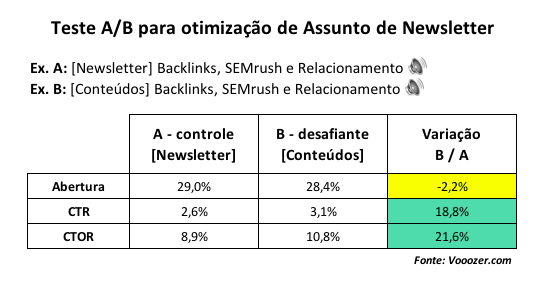

Por isso, sempre que possível executamos testes A/B com nossas newsletters. O teste mais recente foi em relação ao assunto de e-mail das newsletters, com o objetivo de aumentar as visitas ao no blog.

Definimos que a variável dependente, aquela que queríamos melhorar, seria o CTR. Ou seja, a [quantidade de cliques nos conteúdos] dividida pela [quantidade de e-mails enviados].

A ideia era descobrir se poderíamos ter melhores resultados trocando o assunto das newsletters, que normalmente começavam com “[Newsletter]”. A variável independente, portanto, foi o assunto do e-mail.

Nosso padrão era “[Newsletter]” e na sequência 3 palavras-chave relacionadas aos artigos sendo divulgados. Por exemplo:

- [Newsletter] Storytelling, Mobile first, Conversão e mais 🔊

Começar o assunto com “[Newsletter]” era o controle e definimos como desafiante a palavra “Conteúdos”. Assim, para o exemplo acima, o assunto desafiante seria:

- [Conteúdos] Storytelling, Mobile first, Conversão e mais 🔊

Fizemos alguns disparos para um número controlado de destinatários, sempre nessa linha de “Newsletter” vs “Conteúdos”, pois um único disparo não traria tanta validade aos resultados.

Após alguns disparos, a surpresa! Embora o desafiante tivesse tido um pouco menos de porcentagem de abertura que o controle, as taxas de cliques foram 19% superiores!

Ou seja, menos pessoas abriam o e-mail desafiante, mas mais pessoas clicavam nos conteúdos do e-mail.

No resultado geral dos testes, o desafiante obteve um CTR que foi 18,8% superior ao controle, como você pode ver na tabela a seguir:

É difícil interpretar ou realmente entender essa variação. Afinal, todo o corpo do e-mail, inclusive os conteúdos sendo divulgados, eram sempre iguais nos dois casos.

Mas, se tivesse que chutar, eu diria que as pessoas tendem a abrir newsletters por obrigação, sem um intuito tão forte de consumir os materiais.

Ao passo que a palavra “conteúdos”, nada sexy mas ligada a consumo e aprendizado, pode acabar disparando diferentes gatilhos na mente das pessoas, resultando em mais cliques.

Acontece que um dos pontos fascinantes sobre os testes A/B é justamente isso: você não precisa saber explicar a variação dos indicadores para poder escolher a melhor opção e passar a gerar ainda mais resultados em suas ações.

Agora você está pronto para conduzir seus testes A/B e analisar os resultados.

Espero que tenha gostado desse artigo. Até a próxima!